La Ley de IA es el primer marco jurídico sobre IA, que aborda los riesgos de la IA y posiciona a Europa para desempeñar un papel de liderazgo a nivel mundial.

La Ley de IA [Reglamento(UE) 2024/1689 por el que se establecen normas armonizadas sobre inteligencia artificial]ofrece a los desarrolladores e implementadores de IA requisitos y obligaciones claros en relación con los usos específicos de la IA. Al mismo tiempo, el Reglamento pretende reducir las cargas administrativas y financieras para las empresas, en particular las pequeñas y medianas empresas (pymes).

La Ley de IA forma parte de un paquete más amplio de medidas políticas para apoyar el desarrollo de una IA fiable, que también incluye el paquete de innovación en materia de IA y el plan coordinado sobre IA. En conjunto, estas medidas garantizan la seguridad y los derechos fundamentales de las personas y las empresas en lo que respecta a la IA. También refuerzan la adopción, la inversión y la innovación en IA en toda la UE.

La Ley de IA es el primer marco jurídico integral sobre IA en todo el mundo. El objetivo de las nuevas normas es fomentar una IA fiable en Europa y fuera de ella, garantizando que los sistemas de IA respeten los derechos fundamentales, la seguridad y los principios éticos y abordando los riesgos de modelos de IA muy potentes e impactantes.

La Ley de IA garantiza que los europeos puedan confiar en lo que la IA tiene para ofrecer. Si bien la mayoría de los sistemas de IA presentan un riesgo limitado o nulo y pueden contribuir a resolver muchos retos sociales, determinados sistemas de IA crean riesgos que debemos abordar para evitar resultados indeseables.

Por ejemplo, a menudo no es posible averiguar por qué un sistema de IA ha tomado una decisión o predicción y ha tomado una acción en particular. Por lo tanto, puede ser difícil evaluar si alguien ha sido injustamente desfavorecido, como en una decisión de contratación o en una solicitud de un plan de beneficios públicos.

Aunque la legislación vigente ofrece cierta protección, es insuficiente para abordar los retos específicos que pueden plantear los sistemas de IA.

Las nuevas normas:

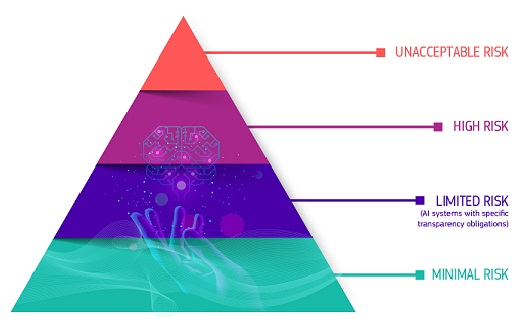

El marco regulador define cuatro niveles de riesgo para los sistemas de IA:

Todos los sistemas de IA considerados una clara amenaza para la seguridad, los medios de subsistencia y los derechos de las personas están prohibidos, desde la puntuación social por parte de los gobiernos hasta los juguetes que utilizan asistencia de voz que fomentan comportamientos peligrosos.

Los sistemas de IA identificados como de alto riesgo incluyen la tecnología de IA utilizada en:

Los sistemas de IA de alto riesgo están sujetos a obligaciones estrictas antes de que puedan introducirse en el mercado:

Todos los sistemas de identificación biométrica remota se consideran de alto riesgo y están sujetos a requisitos estrictos. El uso de la identificación biométrica remota en espacios de acceso público con fines policiales está, en principio, prohibido.

Se definen y regulan estrictamente excepciones limitadas, como cuando sea necesario para buscar a un niño desaparecido, prevenir una amenaza terrorista específica e inminente o detectar, localizar, identificar o enjuiciar a un autor o sospechoso de un delito grave.

Dichos usos están sujetos a la autorización de un órgano judicial u otro organismo independiente y a límites adecuados en el tiempo, el alcance geográfico y las bases de datos consultadas.

El riesgo limitado serefiere a los riesgos asociados con la falta de transparencia en el uso de la IA. La Ley de IA introduce obligaciones específicas de transparencia para garantizar que los seres humanos estén informados cuando sea necesario, fomentando la confianza. Por ejemplo, cuando se utilizan sistemas de IA como los chatbots, los humanos deben ser conscientes de que están interactuando con una máquina para que puedan tomar una decisión informada de continuar o dar un paso atrás. Los proveedores también deben garantizar que el contenido generado por la IA sea identificable. Además, el texto generado por la IA publicado con el fin de informar al público sobre asuntos de interés público debe etiquetarse como generado artificialmente. Esto también se aplica al contenido de audio y video que constituye falsificaciones profundas.

La Ley de IA permite el uso gratuito de IA de riesgo mínimo. Esto incluye aplicaciones como videojuegos habilitados para IA o filtros de spam. La gran mayoría de los sistemas de IA utilizados actualmente en la UE entran en esta categoría.

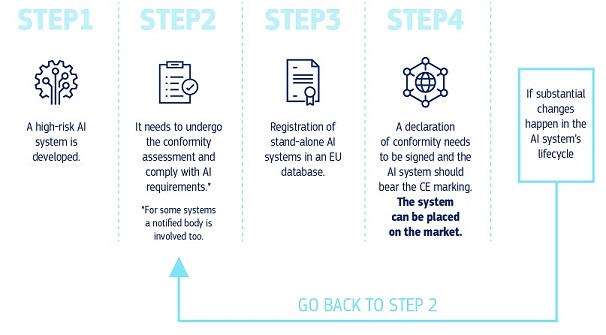

How does it all work in practice for providers of high risk AI systems?

Una vez que un sistema de IA está en el mercado, las autoridades están a cargo de la vigilancia del mercado, los implementadores garantizan la supervisión y el seguimiento humanos, y los proveedores cuentan con un sistema de seguimiento posterior a la comercialización. Los proveedores y los implementadores también informarán de incidentes graves y fallos de funcionamiento.

Cada vez más, los modelos de IA de propósito general se están convirtiendo en componentes de los sistemas de IA. Estos modelos pueden realizar y adaptar innumerables tareas diferentes.

Si bien los modelos de IA de propósito general pueden permitir soluciones de IA mejores y más potentes, es difícil supervisar todas las capacidades.

Allí, la Ley de IA introduce obligaciones de transparencia para todos los modelos de IA de propósito general para permitir una mejor comprensión de estos modelos y obligaciones adicionales de gestión de riesgos para modelos muy capaces e impactantes. Estas obligaciones adicionales incluyen la autoevaluación y la mitigación de los riesgos sistémicos, la notificación de incidentes graves, la realización de pruebas y evaluaciones de modelos, así como los requisitos de ciberseguridad.

Como la IA es una tecnología en rápida evolución, la regulación tiene un enfoque a prueba de futuro, lo que permite que las reglas se adapten al cambio tecnológico. Las aplicaciones de IA deben seguir siendo fiables incluso después de su introducción en el mercado. Esto requiere una gestión continua de la calidad y el riesgo por parte de los proveedores.

La Oficina Europea de IA, creada en febrero de 2024 en el seno de la Comisión, supervisa el cumplimiento y la aplicación de la Ley de IA con los Estados miembros. Su objetivo es crear un entorno en el que las tecnologías de IA respeten la dignidad humana, los derechos y la confianza. También fomenta la colaboración, la innovación y la investigación en IA entre varias partes interesadas. Además, participa en el diálogo y la cooperación internacionales sobre cuestiones de IA, reconociendo la necesidad de una alineación global en la gobernanza de la IA. A través de estos esfuerzos, la Oficina Europea de IA se esfuerza por posicionar a Europa como líder en el desarrollo ético y sostenible de las tecnologías de IA.

La Ley de IA entró en vigor el 1 de agosto y será plenamente aplicable 2 años después, con algunas excepciones: las prohibiciones surtirán efecto al cabo de seis meses, las normas de gobernanza y las obligaciones para los modelos de IA de uso general serán aplicables al cabo de doce meses y las normas para los sistemas de IA —integrados en productos regulados— se aplicarán al cabo de treinta y seis meses. Para facilitar la transición al nuevo marco regulador, la Comisión ha puesto en marcha el Pacto sobre la IA, una iniciativa voluntaria que pretende apoyar la futura aplicación e invita a los desarrolladores de IA de Europa y de fuera de ella a cumplir con antelación las obligaciones clave de la Ley de IA.

Fuente: European Commission Website

Audiovisual: Photographer: Ferenc Isza European Union, 2011 Source: EC - Audiovisual Service